AnthropicAI最新推出的10万token模型:对大型文档与书籍进行语言模型学习的崭新尝试??️

AnthropicAI的新款10万token模型,为大型文档或书籍的语言模型学习(LLM)任务提供了新的可能。这令人不禁开始思索,它与微调(fine-tuning)和上下文学习(in-context learning)之间的关系 – 是优势还是劣势,或者只在特定情况下才具备优势?

如果考虑极端情况,假设上下文窗口无限大,那么将所有数据置于提示(prompt)中就如同进行一次性的微调。

优点:

- 同微调一样,可以明确让模型接触到你的全部知识,只不过是在输入中,而不是在微调后的权重(weights)中。

- 相较于Embedding,无需额外编写代码。

- 相对微调,更方便地加入新的数据。

缺点:

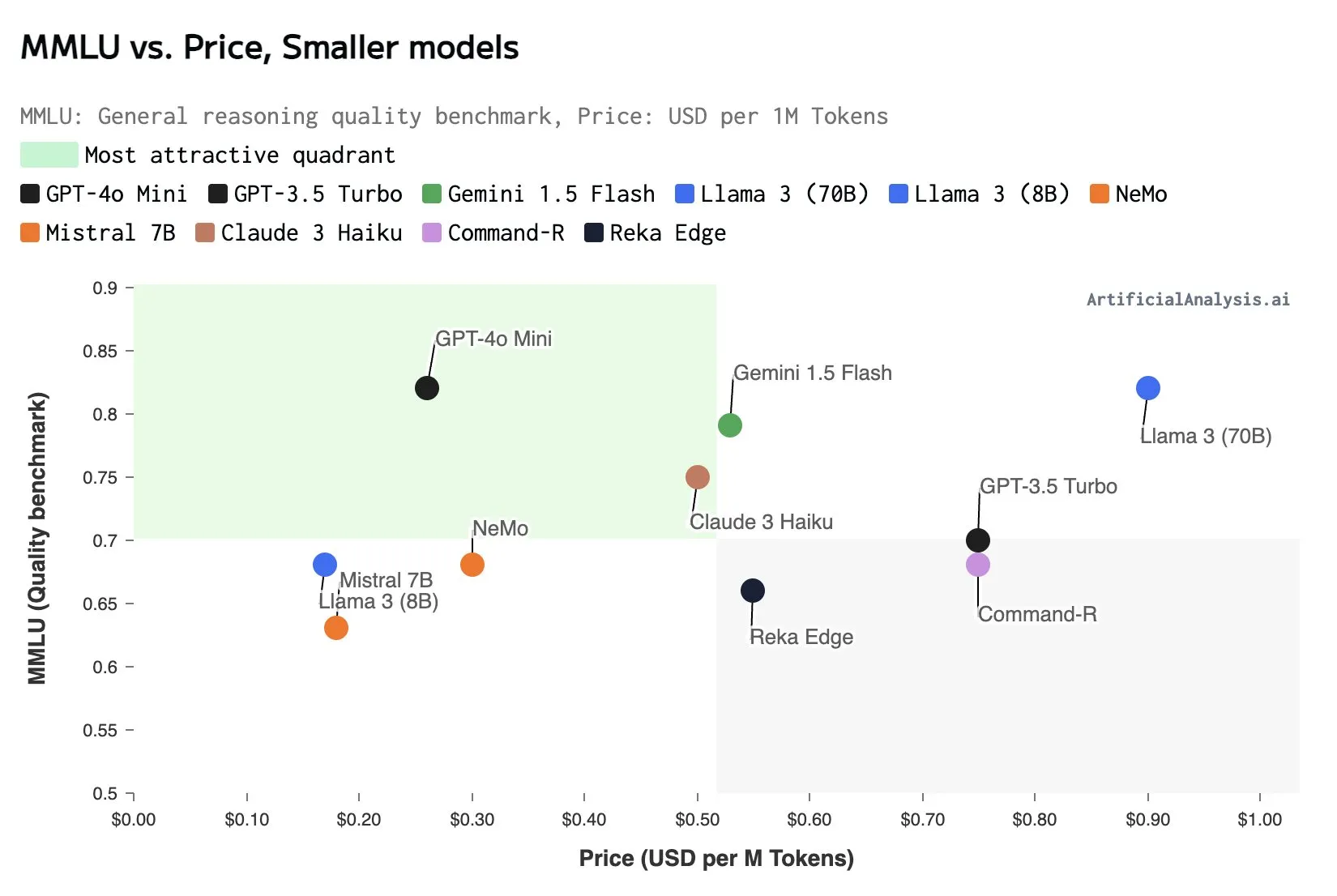

- 每次推理调用都需要重复输入所有数据。

- 因此,边际成本和延迟将显著增加。

尽管Embedding在功能上更为有限(因为它本质上需要一些代码操作和向量数据存储),但另一方面,它能降低成本和延迟。那么,这种将所有内容都输入到提示中的方法,究竟是一种完美的妥协,还是两头不讨好的最差选择?

回归10万个token的上下文窗口问题:10万个token已经相当大了,但如果你有千兆或兆字节的数据,10万个token无法装下所有的内容(例如无法装下UBER SEC的文件)。因此,你仍需从你的数据中进行一些检索,特别是在没有微调的情况下。问题就变成了,你是否总是希望最大化上下文窗口,或者你是否愿意去分块检索。

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。