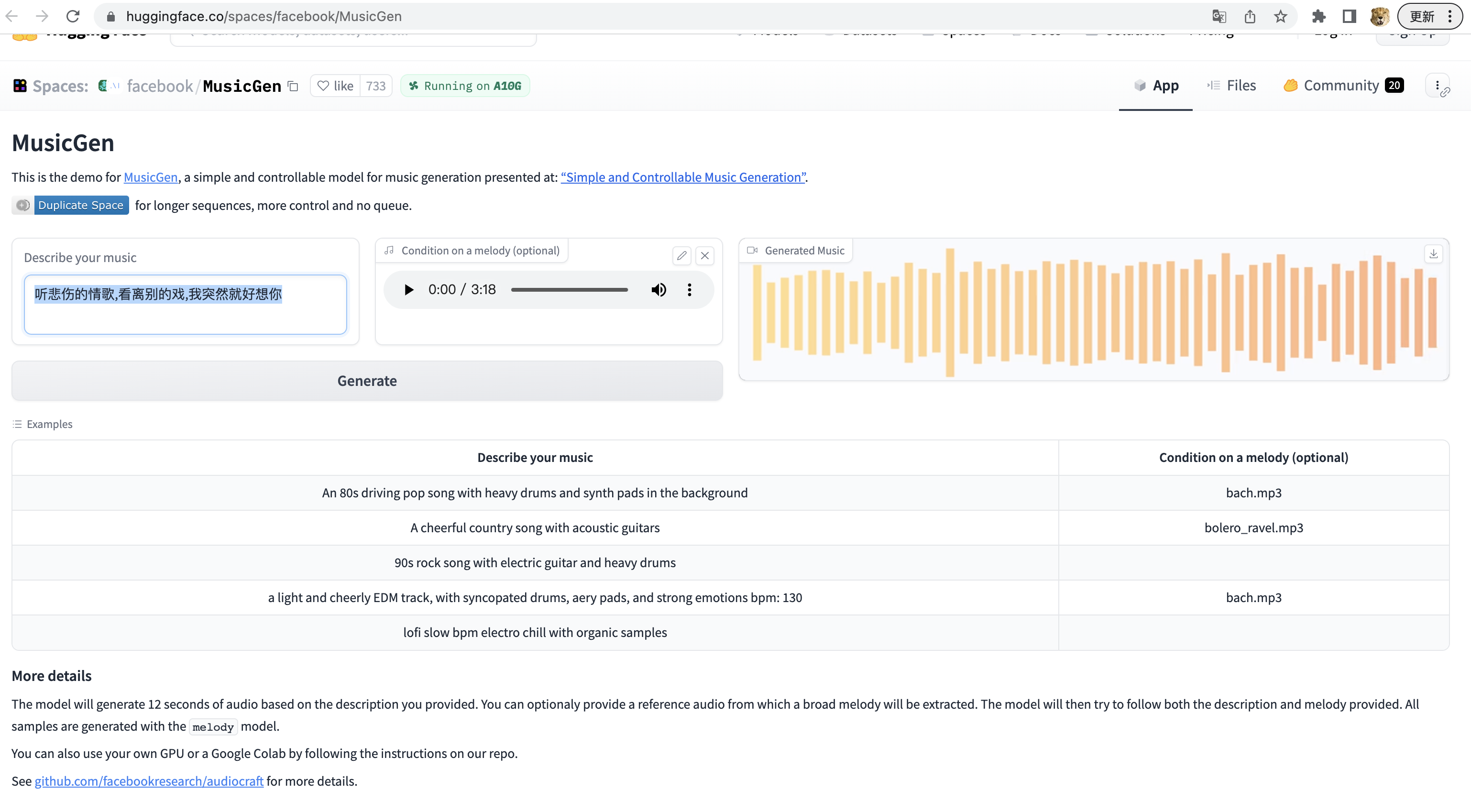

以下为参考《听悲伤的情歌》并以“听悲伤的情歌,看离别的戏,我突然就好想你”为提示词生成的音乐

Meta的MusicGen是一种AI音乐生成器,它能根据文本提示生成音乐。与Google的音乐生成器不同,Meta将MusicGen开源了。MusicGen可以根据文本描述(例如“带有重鼓和合成器垫声的80年代驾驶流行歌曲”)生成大约12秒的音频。MusicGen还可以选择性地使用参考音频进行“引导”,如现有的歌曲,在这种情况下,它将试图遵循描述和旋律。

MusicGen使用了Transformer架构,能够根据文本提示生成新的音乐片段。与语言模型类似,MusicGen预测的是音乐片段的下一部分,而不是句子中的下一个字符。这使得它能够生成连贯和结构化的音乐作品。

Meta表示,MusicGen在20000小时的音乐上进行了训练,包括10000首“高质量”许可音乐曲目和来自ShutterStock和Pond5的390000首仅包含乐器的曲目。Meta没有提供用于训练模型的代码,但它已经提供了预训练模型,任何拥有合适硬件的人(主要是拥有大约16GB内存的GPU)都可以运行。

MusicGen的一个关键特性是能够处理文本和音乐提示。文本提示设置了基本风格,然后与音频文件中的旋律匹配。例如,通过将描述特定音乐风格的文本提示与著名作品的旋律相结合,MusicGen可以生成反映所需风格的新音乐作品。

研究人员试验了不同大小的模型,从3亿到33亿参数不等。他们发现,更大的模型通常产生更高质量的音频,但是1.5亿参数的模型被人类评估者评为最佳。3.3亿参数的模型在准确匹配文本输入和音频输出方面表现出色。

Meta已经在GitHub上开源了MusicGen的代码和模型,允许研究人员和商业用户访问和使用这项技术。这一举动鼓励了AI生成音乐领域的进一步发展、合作和创新。

虽然MusicGen的歌曲合理地旋律化,至少对于像“环境芯片音乐”这样的基本提示是这样,并且在我看来,它的结果与Google的AI音乐生成器MusicLM相当(如果不是稍微好一点),但它们还无法赢得任何奖项。

虽然生成音乐正在明显改进(参见Riffusion,Dance Diffusion和OpenAI的Jukebox),但主要的道德和法律问题还有待解决。像MusicGen这样的AI从现有音乐中“学习”以产生类似的效果,这一事实并不是所有艺术家或生成AI用户都能接受的。

越来越多使用生成AI的家庭制作的轨道能够产生熟悉的声音,这些声音可以被视为真实的,或至少接近真实,这些轨道已经引发了病毒式传播。音乐标签已经快速地将它们标记给流媒体合作伙伴,引用知识产权问题,并且他们通常都能够获胜。但是,关于“深度伪造”音乐是否侵犯艺术家、标签和其他权利所有者的版权,仍然缺乏明确性。

在这方面可能不久就会有指导意见。几起正在法院审理的诉讼可能会对音乐生成AI产生影响,包括一个涉及未经他们知情或同意就使用他们的作品来训练AI系统的艺术家的权利的诉讼。

至于Meta,它并没有对MusicGen的使用方式设定限制,它表示,MusicGen接受训练的所有音乐都是“通过与权利持有者的法律协议覆盖”的,包括与Shutterstock的协议。

开源地址:

https://github.com/facebookresearch/audiocraft

体验地址:

https://huggingface.co/spaces/facebook/MusicGen

原音乐: